Aunque toda nueva tecnología informática presenta riesgos, quizás la IA sea de las que más incrementa la magnitud de los riesgos, tanto negativos (por su impacto potencial a nivel organizacional y social) como positivos (por las magníficas oportunidades que ofrece, por ejemplo, para el soporte a las decisiones).

Respecto a los riesgos tradicionales de las TI, hay que tener en cuenta que en la IA estos evolucionan más rápidamente que la mayoría, apareciendo riesgos:

- Legales, cuando los sistemas inteligentes no cumplen las normativas vigentes.

- Éticos, cuando no se piensa sobre el uso que se hace de los sistemas inteligentes.

- Técnicos, cuando la infraestructura software o hardware no asegura la robustez de los sistemas inteligentes.

En cuanto a los aspectos legales destaca sobre todo el Reglamento de IA (AI Act) de la Unión Europea, y a nivel nacional el “Anteproyecto de Ley para el Buen Uso y la Gobernanza de la Inteligencia Artificial ”, que desarrolla el régimen sancionador y de gobernanza previsto en el RIA adaptándolo a la legislación española.

En el plano ético, destaca el informe técnico ISO/IEC TR 24368 Information technology — Artificial intelligence — Overview of ethical and societal concerns, que señala que la ética de la IA es un campo dentro de la ética aplicada y recoge varios marcos éticos y los utiliza para destacar las nuevas preocupaciones éticas y sociales que surgen con la IA. Proporciona además ejemplos de prácticas y de consideraciones para crear y utilizar una IA ética y socialmente aceptable. Por otro lado, son muy prometedoras las dos iniciativas que lidera Juan Pablo Peñarrubia Carrión, Vicepresidente del Consejo de Colegios Profesionales de Ingeniería Informática de España (CCII), sobre este tema en CEN/CENELEC: «Guidelines on tools for handling ethical issues in AI system life cycle» y «Guidance for upskilling organisations on AI ethics and social concerns».

En cuanto al plano técnico, existen multitud de propuestas y más concretamente estándares internacionales para evaluar, asegurar y mejorar la funcionalidad y la calidad de los sistemas inteligentes. Entre estos, destacamos la importancia de unos buenos procesos software para desarrollar sistemas de IA (como refleja la norma ISO/IEC 5338) y un modelo de calidad tanto para el software de la IA (norma ISO/IEC 25029) como de los datos (norma ISO/IEC 5259).

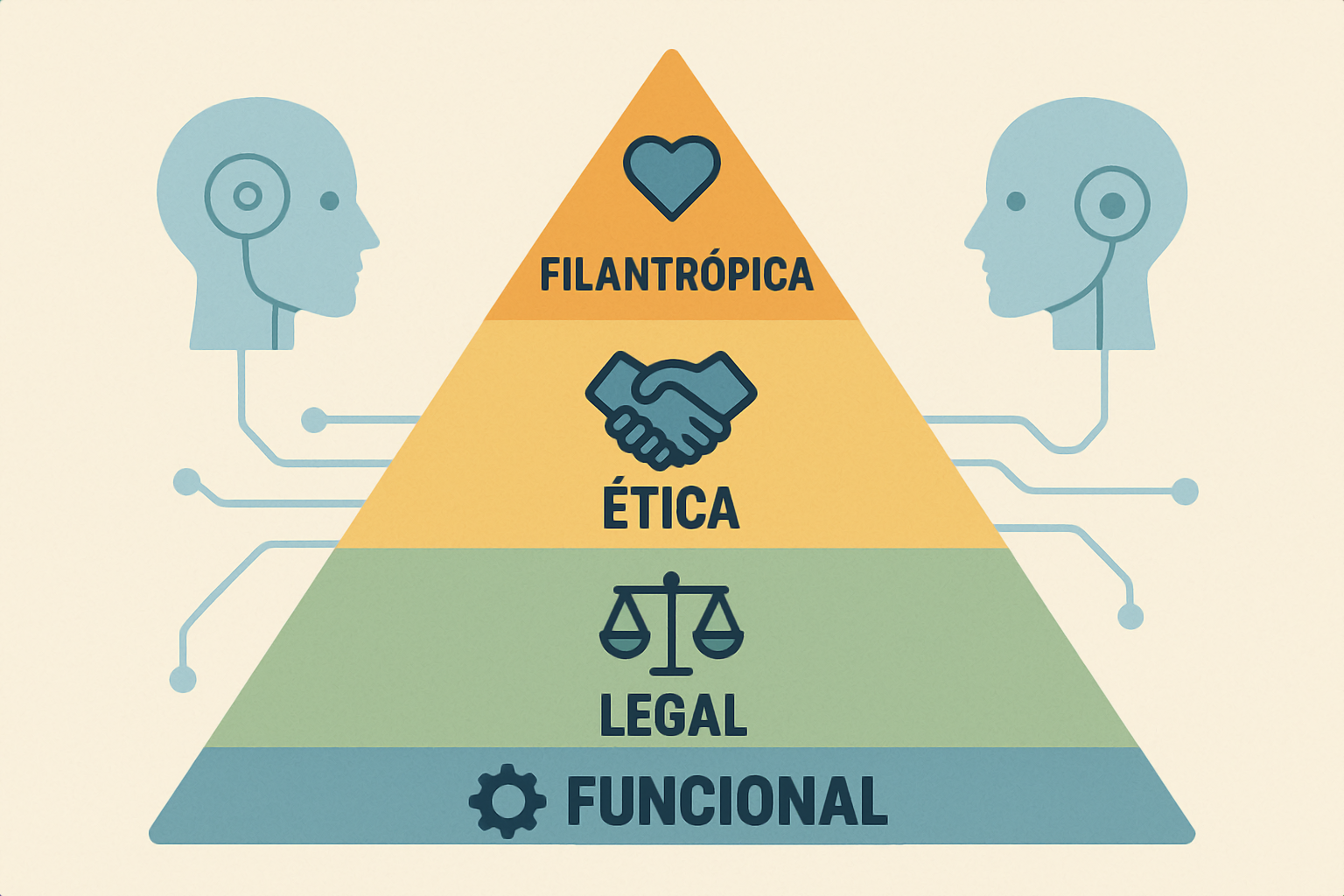

En la “Pirámide Social de la IA”, sus autores identifican cuatro componentes de la responsabilidad social de la IA, empezando por la noción básica de que la adecuación funcional de la IA sustenta todo lo demás. En cuanto al siguiente componente, el legal, se exige que los sistemas de IA actúen de forma coherente con las expectativas del gobierno y la ley, cumpliendo al menos los requisitos legales mínimos. En el nivel siguiente, las responsabilidades éticas son la obligación de hacer lo que es correcto, justo y equitativo, y de evitar o mitigar el impacto negativo para los stakeholders. Por último, en cuanto a las responsabilidades filantrópicas, se espera que existan “buenos ciudadanos de la IA”, que contribuyan a afrontar retos sociales como el cáncer y el cambio climático.

Como podemos observar, la base de toda la pirámide se apoya en que los sistemas inteligentes tienen que ser adecuados funcionalmente y cumplir unos mínimos requisitos de calidad, ya que en caso contrario de poco servirá que cumplan con los requerimientos legales y éticos.

Estamos convencidos que con una IA funcional y de calidad, junto con los sistemas de gestión y de gobierno adecuados, los sistemas inteligentes podrán desarrollar su función filantrópica, que es al final lo más importante, que la IA sirva realmente para mejorar la calidad de vida de las personas y sus organizaciones.